Desde o início do ano, a OpenAI bloqueou com sucesso mais de 20 campanhas maliciosas que tentaram usar indevidamente sua plataforma de IA para crimes cibernéticos e desinformação. Essas operações incluíam depuração de malware, criação de artigos para sites, geração de biografias falsas de mídia social e até mesmo criação de fotos de perfil geradas por IA para contas fraudulentas no X (antigo Twitter).

Apesar da evolução constante das táticas desses agentes maliciosos, a OpenAI declarou que nenhuma dessas atividades levou a avanços significativos na criação de novos malwares. Entre os esforços de desinformação direcionados estavam campanhas vinculadas a eleições nos EUA, Ruanda, Índia e União Europeia, embora nenhuma tenha conseguido construir públicos sustentados ou se tornar viral.

Principais operações cibernéticas bloqueadas

Várias operações cibernéticas notáveis foram destacadas pela OpenAI, incluindo:

- SweetSpecter: Um grupo chinês é suspeito de usar os serviços da OpenAI para pesquisa de vulnerabilidades, suporte a scripts e evasão de detecção. O grupo até tentou atingir funcionários da OpenAI com ataques de spear-phishing para entregar o SugarGh0st RAT.

- Cyber Av3ngers: Ligado ao Corpo da Guarda Revolucionária Islâmica Iraniana (IRGC), este grupo utilizou modelos OpenAI para pesquisa em controladores lógicos programáveis, essenciais para controle de infraestrutura crítica.

- Storm-0817: Outro agente malicioso iraniano, Storm-0817, aproveitou os modelos OpenAI para depurar malware Android capaz de roubar informações confidenciais e raspar perfis do Instagram usando Selenium, além de traduzir perfis do LinkedIn para o persa.

Além disso, a OpenAI fechou grupos de contas falsas, incluindo as operações de influência A2Z e Stop News, ambas gerando conteúdo em inglês e francês para redes sociais. Notavelmente, a Stop News usou imagens geradas pelo DALL·E em um estilo de desenho animado com cores vibrantes para capturar a atenção.

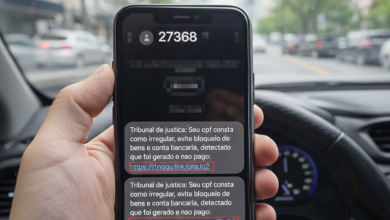

Duas outras redes, Bet Bot e Corrupt Comment, foram encontradas abusando da API da OpenAI para envolver usuários no X promovendo links de jogos de azar e postando comentários fabricados.

Implicações mais amplas no cenário global

Este anúncio segue uma proibição recente pela OpenAI de contas vinculadas ao Storm-2035, uma operação de influência secreta iraniana que usa o ChatGPT para criar conteúdo direcionado à eleição presidencial dos EUA.

De acordo com os pesquisadores Ben Nimmo e Michael Flossman, os agentes de ameaças frequentemente empregavam os modelos da OpenAI para fases intermediárias de suas operações, coleta de informações e criação de conteúdo antes de lançar suas campanhas.

As ferramentas de IA generativa, de acordo com especialistas em segurança cibernética, apresentam o risco de serem usadas para amplificar informações incorretas.

Um relatório recente da Sophos enfatizou o perigo de usar IA para criar e-mails microdirecionados que espalham desinformação personalizada. Personas políticas e mensagens de campanha geradas por IA podem potencialmente manipular a opinião pública com um alto grau de automação e precisão.