Caros leitores(a) vamos começar com uma certeza desconfortável quando você concorda em tirar uma selfie para “verificar sua identidade” no site que promete chat com inteligência artificial, você não está apenas autorizando um OCR esperto a ler seu documento.

Existe um sistema inteiro construído por uma empresa chamada Persona em parceria com grandes players e agências preparado para catalogar, comparar e… bem, digamos, vigiar você um tiquinho além do que você imaginou.

No fundo, isso não é um café da manhã com o vizinho. É uma arquitetura sofisticada de vigilância digital que foi desvendada pelo VmFunc.Re depois que 53 megabytes de código fonte sim, código não criptografado, útil, real e interpretável vazaram de um endpoint governamental que deveria estar seguro.

Esses arquivos estavam disponíveis por meio de fontes públicas como logs de transparência de certificados e mapeamento de portas que qualquer curioso pode explorar.

O cenário: conveniência ou invasão?

Do lado promocional, a história te vende assim: “cadastre-se, verifique sua identidade e comece a usar”. Tudo fácil, rápido, seguro. A promessa é de confiança e segurança “trust and safety”, como dizem.

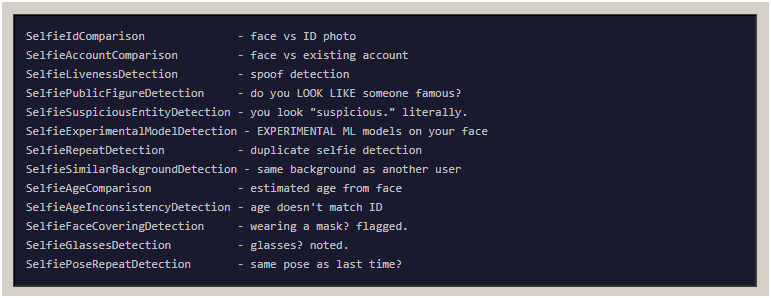

Mas, nos bastidores, o código tinha funções com nomes que fariam qualquer um coçar a cabeça: SelfieSuspiciousEntityDetection. O que isso faz? Compara sua foto não só com seu documento, mas com bancos de dados de listas de vigilância, pessoas politicamente expostas e… bem, praticamente tudo que poderia ser classificado como “suspeito”.

E antes que você pense que isso é uma paranoia digna de roteirista de Hollywood, a realidade é ainda mais absurda: essa infraestrutura estava ativa e rodando há mais de 18 meses antes de a OpenAI sequer anunciar que precisava verificar identidades para liberar seus modelos mais avançados.

Uma arquitetura que não se esconde

Quando se fala em segurança e conformidade, espera-se que sistemas que lidam com dados sensíveis como documentos de identidade sejam extremamente restritos. No caso aqui, não só existia uma instância pública desse backend que ninguém deveria acessar diretamente, como a própria documentação e certificados revelavam detalhes completos da infraestrutura.

Imagine que você está construindo um cofre: não coloca portas de vidro e não indica no letreiro “aqui está o cofre”. Parece óbvio, certo? Pois bem, o código fonte exposto continha literalmente todas as permissões, todos os endpoints, e cada verificação que o sistema pode executar. Não foi uma engenharia reversa exótica: era só abrir os mapas de código e ler.

O que tudo isso faz, afinal?

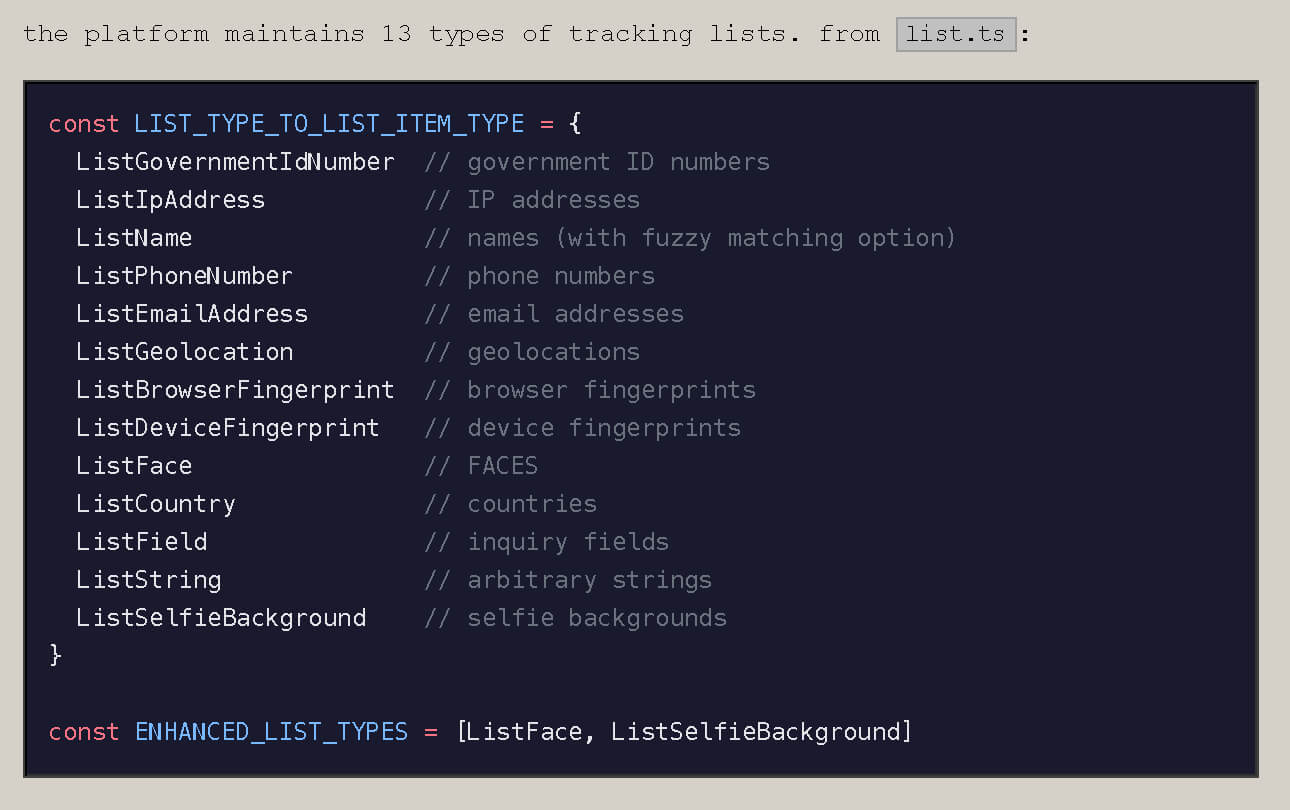

Entre as funcionalidades desse sistema de vigilância digital estão:

- Arquivos de relatórios de atividade suspeita diretamente para o FinCEN, a rede federal de combate à lavagem de dinheiro do Tesouro dos Estados Unidos.

- Comparação facial automática, onde sua selfie é processada para identificar semelhanças com indivíduos que estão em listas de vigilância.

- Reavaliações constantes, para verificar se de repente você “se tornou suspeito” depois de semanas usando o sistema.

- Integração completa com um pacote enorme de verificações, supostamente 269 checagens diferentes contra tudo, desde documentos falsos até indicadores de risco.

Esses não são recursos que você encontra em um app qualquer. São funções de um sistema pensado para monitorar, correlacionar e relatar dados biométricos e comportamentais à máquina estatal.

O governo no meio do caminho

Algo que surpreende (ou não) é descobrir que essa infraestrutura não estava apenas “por trás de um botão” dentro de serviços privados. Ela estava ligada a um domínio que sugeria uso governamental com certificados, logs e implantações que pareciam destinados a órgãos federais, incluindo sistemas especializados que surgiram apenas dias antes da publicação da pesquisa.

E aqui mora uma ironia que nem os roteiristas da Netflix teriam ousado escrever: enquanto o marketing da IA prometia mundos e fundos, esse mecanismo inteiro de vigilância estava em execução silenciosa, coletando, checando e armazenando informações sensíveis em nome de contratos governamentais e padrões de conformidade que o público comum mal entende.

E você pensava que era só um cadastro

Se você está lendo isso e sentindo aquela pontada de desconfiança tipo quando você recebe a notificação de uma compra que você não fez e você se pergunta onde foi que clicou errado bom, você não está sozinho.

O mais bizarro nisso tudo é que nada disso foi um grande vazamento tipo “ataques hackers permitindo invasões”. Foi simplesmente um erro de configuração, combinado com uma arquitetura que foi projetada para ser aberta internamente e acabou exposta ao público.

Isso levanta uma série de questões fundamentais sobre confiança. Especialmente quando as empresas que você acredita que estão cuidando da sua segurança estão operando sistemas que você nem sabia que existiam, e nem sequer avisaram que iriam processar seus dados biométricos desse nível muito menos que poderiam relatar resultados a entidades estatais.

O que aprendemos com esse caso?

A história toda que começou com um IP exposto e acabou revelando uma máquina de vigilância tão complexa quanto uma rede de espionagem deveria servir de alerta para todos que acreditam que conveniência e segurança são sinônimos.

Eles não são. “Verificar sua identidade rapidamente” não foi só um slogan bonito: foi a porta de entrada para um sistema que opera além daquilo que o usuário médio jamais imagina ou consente expressamente.

E aí fica a pergunta, quando a tecnologia promete facilitar nossas vidas, até que ponto estamos dispostos a abrir mão da nossa privacidade? E mais ainda: estamos realmente cientes de quem está olhando para nós enquanto falamos com uma IA?