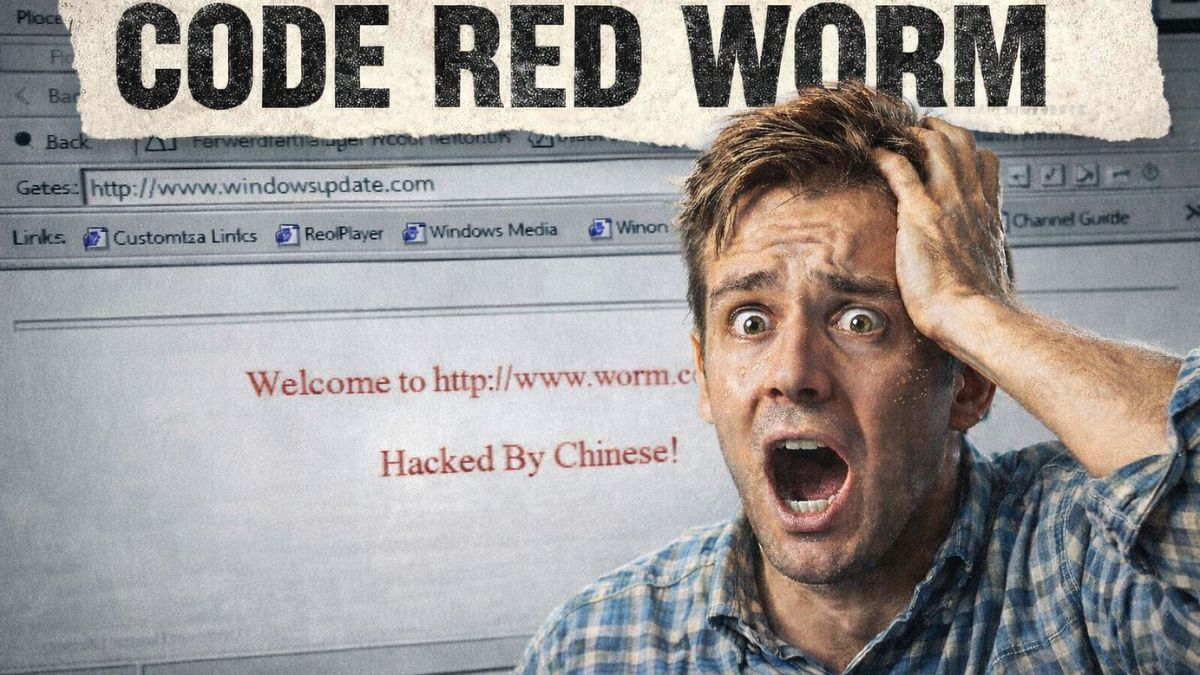

A OpenAI está levando a sério a segurança dos seus modelos de inteligência artificial. Na mais recente atualização trimestral, a empresa confirmou que baniu contas vinculadas a hackers chineses que estavam usando o ChatGPT para escrever e refinar códigos maliciosos.

E não foi só um susto passageiro. Desde que abriu seu sistema de denúncias públicas em fevereiro de 2024, a OpenAI já desmontou mais de 40 redes que tentavam explorar seus modelos de forma indevida.

Como os hackers agiram

O grupo identificado na China combinava sugestões fornecidas pelo ChatGPT com técnicas antigas de exploração. Ou seja, nada de genialidade cibernética, apenas o velho truque com um empurrãozinho da IA.

As investigações mostraram que esses usuários faziam perguntas repetidas sobre cargas maliciosas e apresentavam padrões suspeitos de consulta. Isso acendeu o alerta da equipe de inteligência da OpenAI, que agiu rapidamente.

Quando ficou claro que essas contas violavam as diretrizes de uso da plataforma, elas foram bloqueadas. A partir daí, os hackers perderam o acesso ao ChatGPT e à API.

Não é só a China: ameaças vêm de vários lados

Certamente o grupo chinês foi só mais um caso. O relatório mostra que, no último trimestre, a maioria dos abusos envolveu scripts de phishing assistidos por IA, mensagens de engenharia social automatizadas e códigos feitos para driblar sistemas de detecção.

Essas ameaças não dependem de táticas inéditas. Na verdade, os criminosos estão usando a IA para acelerar processos antigos, otimizando o tempo de ataque sem reinventar a roda.

Como a OpenAI identifica abusos

A detecção de uso malicioso começa com sinais automáticos. O sistema da OpenAI identifica comportamentos como tentativas constantes de gerar shellcodes ofuscados, instruções para criptografar arquivos sem autorização e outros padrões incomuns.

Quando esses gatilhos são ativados, uma equipe especializada revisa os registros das conversas para avaliar a intenção por trás dos pedidos. Se for comprovado uso malicioso, a conta é bloqueada imediatamente.

Compartilhamento com parceiros de segurança

Além do bloqueio direto, a OpenAI compartilha informações relevantes com autoridades, empresas de segurança cibernética e pesquisadores acadêmicos. O objetivo é ampliar a proteção e garantir uma resposta coordenada contra o uso indevido da IA.

Esse compromisso com a transparência e colaboração tem sido um pilar das ações da empresa. Cada novo relatório traz detalhes sobre as ameaças detectadas, as estratégias utilizadas e tendências emergentes.

Um recado claro: não mexe com a IA dos outros

O caso dos hackers chineses serve como alerta. A OpenAI deixou claro que qualquer tentativa de usar seus modelos para fins maliciosos será enfrentada com resposta rápida, pública e decisiva.

A mensagem é simples: abusar da IA não compensa. Especialmente quando se está lidando com sistemas que já foram treinados para detectar e reagir a comportamentos suspeitos.

À medida que a inteligência artificial ganha espaço no cotidiano e também no submundo do cibercrime, empresas como a OpenAI mostram que a prevenção vem antes do lucro.

Monitoramento contínuo, revisão humana e relatórios públicos estão se tornando padrão de defesa. E se depender da OpenAI, o ChatGPT vai continuar sendo uma ferramenta poderosa mas nas mãos certas.

Afinal, o que você acha? As grandes empresas de IA devem agir de forma mais firme contra o uso indevido de suas tecnologias, mesmo que isso afete sua base de usuários?