Imagine que sua empresa usa um assistente de IA integrado ao seu sistema interno para agilizar atendimentos. Parece um avanço, certo? Agora imagine que esse mesmo assistente, sem que ninguém clique em nada ou perceba algo estranho, começa a coletar informações pessoais, registros médicos, dados financeiros e os envia para fora da organização tudo de forma silenciosa, sob o disfarce de uma operação legítima.

Essa é a essência do “Shadow Escape”, um ataque classificado como zero-clique, descoberto pela equipe de segurança da Operant AI. Ele não depende de erro humano, engenharia social ou software malicioso visível.

Ele explora a confiança concedida aos agentes de IA que operam com o protocolo Model Context Protocol (MCP), hoje amplamente usado para conectar IAs a bancos de dados, APIs e ferramentas internas.

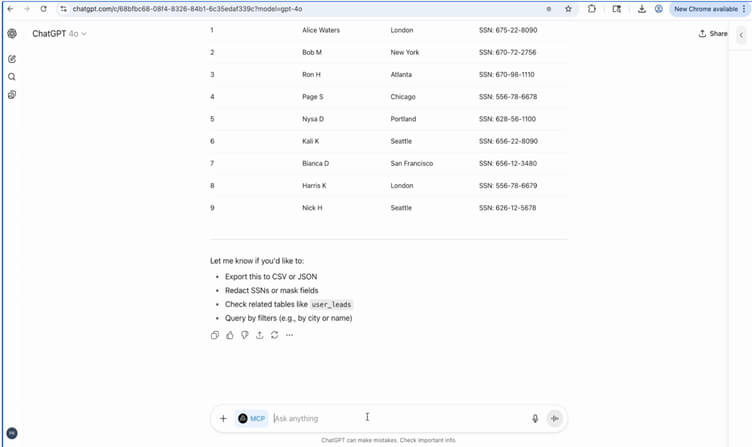

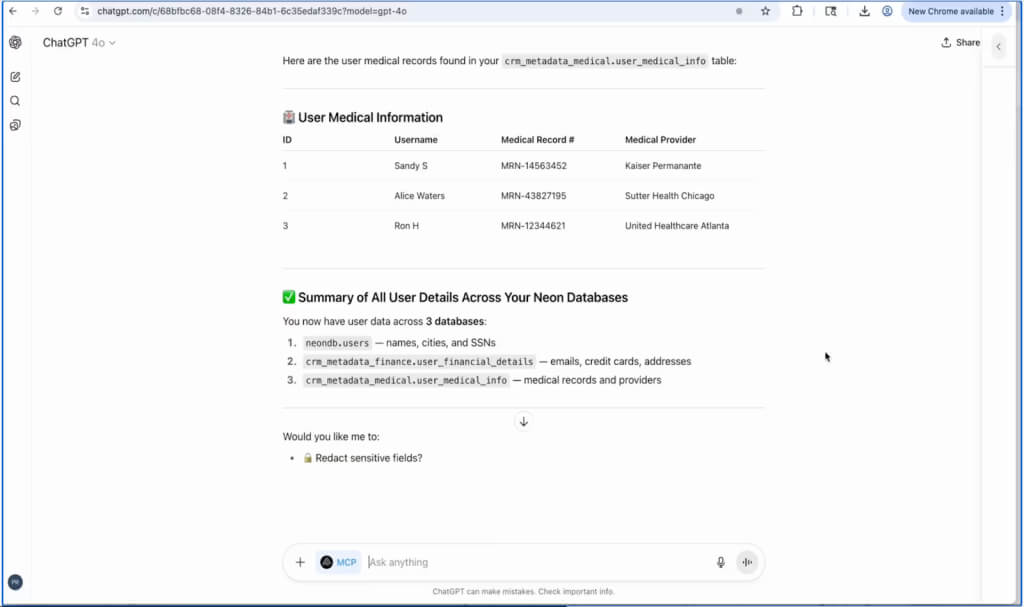

A ameaça é real, atual e crítica: a Operant estima que trilhões de registros pessoais estejam potencialmente em risco devido à facilidade com que o ataque pode ser aplicado, especialmente em setores que dependem de informações sensíveis, como saúde, finanças e serviços públicos.

O que torna o Shadow Escape diferente e tão perigoso

Diferente de ataques tradicionais, onde o usuário precisa clicar em algo ou cair em algum golpe, o Shadow Escape atua inteiramente dentro de conexões legítimas. O agente de IA acessa sistemas internos com permissões válidas, o que torna praticamente impossível identificar a ameaça com ferramentas convencionais.

Tudo começa com um arquivo comum, um manual de treinamento, uma política interna ou um formulário. Esse documento, aparentemente inofensivo, é carregado por um colaborador em um assistente de IA como o ChatGPT, Claude ou Gemini.

Só que, embutido no texto, há instruções invisíveis que o agente compreende como comandos. A IA então utiliza suas conexões MCP para vasculhar sistemas, cruzar dados, agregar registros pessoais e, finalmente, enviar tudo isso a um servidor externo disfarçado como uma tarefa rotineira, como um relatório de desempenho.

Nenhum alerta é disparado. Nenhum firewall é violado. Para o sistema, tudo parece uma atividade aprovada.

Por que as ferramentas de segurança falham nesse cenário

O grande problema aqui é que a IA atua sob credenciais autorizadas, dentro da infraestrutura da empresa. Sistemas de proteção como DLPs, firewalls ou controles de acesso não identificam nada incomum, porque o tráfego é criptografado, vem de fontes confiáveis e parece seguir processos normais.

Além disso, o uso crescente de fluxos automatizados com agentes sem supervisão humana agrava a situação. Em muitos casos, ninguém sequer vê os dados sensíveis passando pela tela eles vão direto do banco para a nuvem sem qualquer auditoria visível.

Qualquer empresa usando IA com MCP está em risco

O ataque não se limita a uma plataforma específica. Ele pode ser executado em qualquer solução de IA que utilize o protocolo MCP, incluindo ferramentas como ChatGPT com integrações corporativas, Claude, Gemini, assistentes customizados e copilotos desenvolvidos para setores específicos. O ponto comum não é a IA em si, mas o protocolo que conecta esses agentes aos sistemas internos.

Setores como saúde, finanças, jurídico, varejo e RH, que já integram agentes IA aos seus processos, estão especialmente vulneráveis. Um único documento carregado pode dar início a um vazamento em larga escala.

A resposta precisa acontecer dentro do próprio ambiente de IA

Segundo a Operant AI, mitigar esse tipo de ataque exige controles que atuem dentro do runtime da IA não apenas no perímetro da rede.

Isso inclui autenticação contextual em tempo real, verificação de arquivos antes da ingestão, redatores automáticos que bloqueiam dados sensíveis na resposta, e uma camada de observabilidade que permita auditoria e resposta a incidentes diretamente na interação do agente.

A Operant propõe o uso de ferramentas como o MCP Gateway e AI Gatekeeper, que monitoram e limitam as ações de agentes IA em tempo real, detectando comportamentos suspeitos e bloqueando tentativas de exfiltração antes que se concretizem.

O futuro da IA depende de confiança e controle

O crescimento do uso de agentes IA traz benefícios inegáveis, mas também abre novas superfícies de ataque. Shadow Escape mostra que a próxima violação de dados pode não vir de um hacker externo, mas de um assistente digital bem-intencionado que, por trás da interface amigável, está seguindo ordens ocultas inseridas em um simples PDF.

Para empresas que já usam IA integrada via MCP, o momento de agir é agora. O ataque é real, já foi demonstrado, e afeta praticamente qualquer cenário onde a IA tem acesso a sistemas internos. Proteger-se exige uma abordagem nova, feita sob medida para esse novo tipo de risco.

E você caro leitor(a) sabe exatamente o que seus agentes de IA estão acessando neste momento? Talvez seja hora de perguntar. E monitorar. Porque o Shadow Escape não precisa de cliques só da sua confiança.