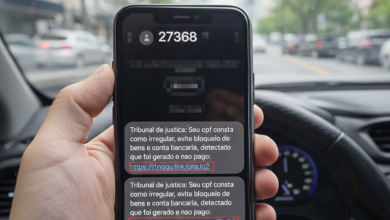

Colocar um servidor de IA na internet sem autenticação é o novo “admin:admin” do século XXI. Parece piada, mas foi isso que a equipe da Cisco Talos encontrou: mais de 1.100 instâncias do Ollama uma framework usada para rodar modelos de linguagem localmente expostas publicamente na web, sem nem um mísero controle de acesso. E o mais grave: cerca de 20% delas ativamente vulneráveis.

Tudo isso em apenas dez minutos de varredura no Shodan o Google das brechas de segurança.

O que é o Ollama (e por que isso importa)?

Ollama é um projeto que facilita a execução de modelos de linguagem grandes (LLMs) localmente. Quer brincar com LLaMA, GPT-4, Mistral ou Falcon na sua máquina, sem depender de APIs caras e com controle? É com ele mesmo.

Agora, pense nisso rodando livremente na internet, sem senha, sem bloqueio de IP, sem validação. Pois é.

O que os pesquisadores encontraram?

Foram 1.140 instâncias do Ollama expostas. Destas, 228 estavam abertas, rodando modelos prontos para serem explorados por qualquer um com um navegador ou uma linha de comando.

Algumas das vulnerabilidades possíveis:

- Extração de modelo: Atacantes podem explorar a API repetidamente e reconstruir os pesos do modelo o famoso “model leakage”. Aquele LLaMA treinado com suor e dados confidenciais? Pode virar arquivo zipado no fórum underground rapidinho.

- Jailbreak e geração de conteúdo malicioso: Sem barreiras, dá pra fazer o modelo cuspir código malicioso, desinformação ou qualquer outro lixo que o usuário quiser provocar. E sim, até GPT-4 entra nessa jogada.

- Backdoor e envenenamento: Se a API permite uploads ou comandos inseguros, o atacante pode injetar um modelo trojanizado, que se comporta normalmente… até decidir não mais.

E os “inativos”? Também são problema

Mesmo os 912 servidores restantes, classificados como “inativos”, são riscos sérios. Eles podem:

- Ser reativados sem patch

- Ser explorados por DoS

- Ser manipulados via configuração

- Ser usados como porta de entrada para redes maiores

Além disso, muitos expunham metadados sensíveis: caminhos de sistema, strings de versão, configs de rede tudo o que um atacante adora para fazer um mapa completo da sua infraestrutura.

Onde estão esses servidores?

Distribuição global:

- EUA: 36,6%

- China: 22,5%

- Alemanha: 8,9%

Um detalhe chama atenção: muitos desses servidores foram instalados fora do controle dos times de TI, escapando de auditorias, firewalls e qualquer senso de segurança corporativa. É o dev que viu um repositório massa, testou local, achou legal… e sem querer expôs uma IA potente direto na internet.

O problema vai além do Ollama

A familiaridade dos endpoints já que muitos seguem o estilo das APIs do OpenAI permite que explorações feitas para GPT também funcionem no Ollama. Ou seja, com pequenas adaptações, um atacante consegue escalar exploits para diversas plataformas.

E esse é o ponto mais crítico: a facilidade com que ameaças podem pular de uma stack para outra. É o pesadelo moderno da segurança em IA.

E o mais importante…

A Cisco deixou claro, esse levantamento com o Shodan mostra só a pontinha do iceberg. A maioria dos frameworks de IA ainda está fora do radar. Sistemas como Hugging Face Transformers, Triton, vLLM e tantos outros ainda não estão sendo rastreados com profundidade.